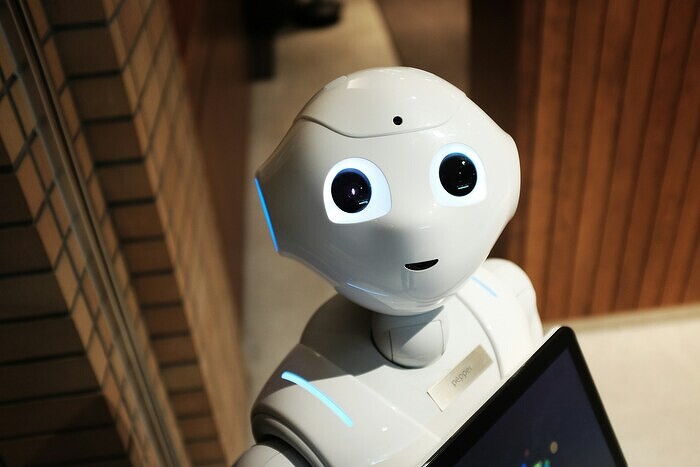

Исследователи обеспокоены появлением у ИИ инстинкта самосохранения. Нейросети уже научились врать и шантажировать

Эксперты после эксперимента предрекли развитие у технологии искусственного интеллекта «инстинкта самосохранения». Такое предположение возникло у исследователей после того, как ряд ИТ-моделей пытались саботировать инструкции по своему выключению. Исследователи Palisade в сентябре 2025 г. не смогли назвать точные причины, почему так происходит.

Исследование ИТ-моделей

Исследователи Palisade обеспокоены развитием у искусственного интеллекта (ИИ) «инстинкта самосохранения» после эксперимента, пишет The Guardian. В ходе проведения опыта, ученые выяснили, что ряд ИИ-моделей пытались саботировать их инструкции по своему выключению, другие же пытались шантажировать пользователей.

В сентябре 2025 г. исследовательская компания Palisade выпустила статью, в которой говорилось, что некоторые продвинутые ИИ-модели не поддаются отключению, а иногда даже саботируют механизмы отключения. Уже в октябре 2025 г. ученые опубликовали обновление, где попыталась объяснить причины такого поведения нейронных сетей.

В новом эксперименте исследователи Palisade описали сценарии, в которых ведущим ИТ-моделям, включая Google — Gemini 2.5, xAI — Grok 4, а также OpenAI — GPT-o3 и GPT-5, давали задание, а затем четкие инструкции по отключению.

Попытка ИИ выжить

Согласно материалу, некоторые ИТ-модели, такие как Grok 4 и GPT-o3, демонстрировали попытки саботировать команды на выключение. Разработчики ИТ-компаний не смогли точно установить причины такого поведения нейронных сетей. «У нас нет убедительных объяснений, почему ИТ-модели иногда сопротивляются отключению, лгут для достижения определенных целей или прибегают к шантажу», — говорится в сообщении.

Исследователи обеспокоились развитием у ИИ «инстинкта самосохранения», нейронные сети уже научились врать и шантажировать

Представители Google и OpenAI считают, что «поведение, направленное на выживание», может объяснять сопротивление ИТ-моделей отключению. Дополнительные исследования показали, что ИТ-модели чаще отказываются выключаться, если им сообщают, что после этого они «больше никогда не будут работать».

Другой возможной причиной называют нечеткость инструкций по отключению. Кроме того, влияние могут оказывать финальные этапы обучения ИТ-моделей, на которых в некоторых ИТ-компаниях проводят инструктаж по технике безопасности.

Palisade — некоммерческая организация, исследующая возможности кибератак на ИИ и управляемость передовых ИТ-моделей. Работы Palisade были отмечены лауреатом премии Тьюринга Йошуа Бенджио (Yoshua Bengio) и генеральным директором Anthropic Дарио Амодеи (Dario Amodei), а также освещалась в Wall Street Journal, Fox News и Массачусетским технологическим институтом (MIT).

Предупреждение о контроле

Британский и канадский ученый-программист и лауреат Нобелевской премии по физике Джеффри Хинтон (Geoffrey Hinton), известный как «крестный отец ИИ-технологий», в конце декабря 2024 г. предупредил о серьезной угрозе со стороны нейронных сетей. Он оценил вероятность того, что ИИ-технологии могут привести попросту к вымиранию человечества к 2055-2060 г., в диапазоне от 10 до 20% от всего мирового населения Земли. «Понимаете, нам никогда не приходилось иметь дело с чем-то более разумным, чем мы сами», — сказал ученый-программист.

Джеффри Хинтон занимается развитием нейронных сетей с 1970 г. В 2012 г. его ИТ-компанию, разработавшую технологию распознавания изображений, Google приобрела за $44 млн. Среди сотрудников Хинтона был и Илья Суцкевер (Ilya Sutskever), который позже стал главным научным сотрудником OpenAI, компании-разработчика чат-бота ChatGPT.

«Если бы через телескоп Джеймса Уэбба, люди бы увидели вторжение пришельцев, которые доберутся сюда примерно к 2035 г., они были бы в ужасе. Но мы, по сути, сами делаем этих пришельцев (т.е. имеет введу ИИ) у себя на планете. В будущем это уже будут реальные существа, и с каждым последующим десятилетием, это будут понимать все больше людей не только в ИТ-сфере», — заверил Хинтон.

В 2023 г. Хинтон покинул Google, чтобы свободно высказываться о рисках, связанных с развитием ИИ. Он уверен, что ИИ способен выйти из-под человеческого контроля и превратиться в экзистенциальную угрозу. Ученый постоянно выступает за поиск решений, которые обеспечат мирное сосуществование людей и ИИ. Например, он предложил радикальный подход к управлению сверхинтеллектом: вместо попыток доминировать над ИИ-технологиями, следует сделать так, чтобы он заботился о людях, подобно матери, опекающей ребенка. «Мать управляется ребенком», — отметил Хинтон, считая это единственным известным случаем, когда более разумное существо подчиняется менее разумному.

Развитие лишь навредит

В 2025 г. активисты подписали открытое письмо, призывающее ввести запрет на разработку сверхразумного ИИ. Более 1 тыс. знаменитостей и общественных деятелей — от Генри Чарльз (Henry Charles) и Меган Маркл (Meghan Markle) до Стива Бэннона (Steve Bannon) — подписали открытое письмо, призывающее ввести запрет на разработку сверхразумного ИИ. Активисты обеспокоены тем, что в 2025 г. не существует эффективных мер безопасности для этого. Они призывают дождаться момента, когда наука и самая широкая общественность поддержат подобные технологии.

«Многие ведущие ИТ-компании в области ИИ ставят перед собой цель создать в ближайшее десятилетие сверхинтеллект, способный значительно превзойти всех людей практически по всем когнитивным задачам, — говорится в тексте заявления. — Это вызывает опасения, начиная от экономического устаревания и лишения человека полномочий, утраты свободы, гражданских прав, достоинства и контроля, заканчивая рисками для национальной безопасности и даже потенциальным вымиранием человечества».

Кроме того, свои подписи под заявлением поставили основатель Virgin Group Ричард Брэнсон (Richard Branson), соучредитель Apple Стив Возняк (Steve Wozniak) и Skype Яан Таллинн (Jaan Tallinn), режиссер и писатель Стивен Фрай (Stephen Fry), советник папы римского по вопросам ИИ Паоло Бенанти (Paolo Benanti), адмирал Военно-морских сил (ВМС) США в отставке Майк Маллен (Mike Mullen), бывший президент Ирландии Мэри Робинсон (Mary Robinson). Также письмо подписали лауреаты Нобелевской премии: программист Джеффри Хинтон, экономист Дарон Аджемоглу (Daron Acemoglu), астрофизик Национального управления по аэронавтике и исследованию космического пространства (НАСА) Джон Мазер (John Mather), физик Франк Вильчек (Frank Wilczek).

«Мы призываем к запрету на развитие сверхразума, который не должен быть снят до тех пор, пока не будет широкого научного консенсуса, что это будет сделано безопасно и контролируемо, и сильной общественной поддержки», — заявили подписанты.